La explosión de la inteligencia artificial, a finales del 2022, nos sumergió en el intenso debate de la tecnología sustituyendo a los humanos en todas las actividades laborales. La posibilidad de este escenario se ha abordado de distintas formas con diferentes visiones. Pero para determinar si esto sucederá en un futuro hay que responder si las máquinas están capacitadas para la toma de decisiones morales.

PUBLICIDAD

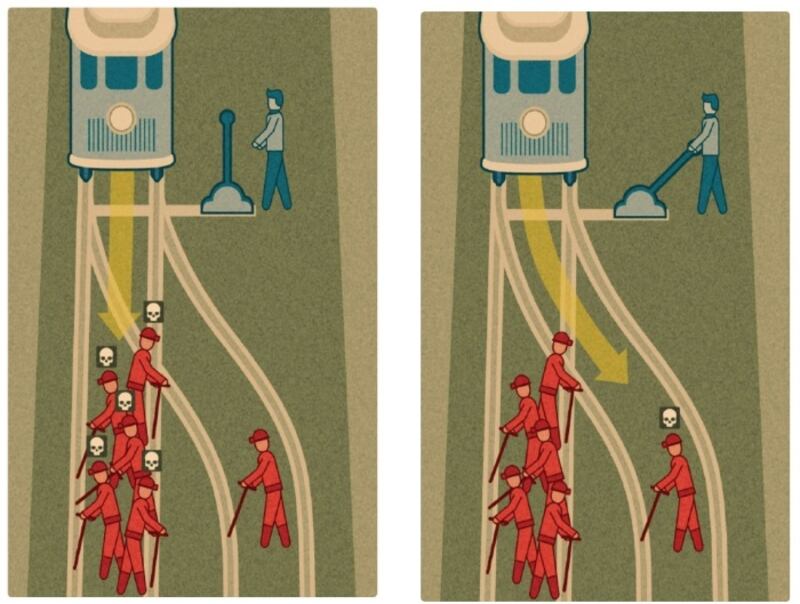

Un tren a toda velocidad y descontrolado por las vías está a punto de arrollar a cinco personas. Un individuo tiene en sus manos la posibilidad de halar una palanca y cambiar los rieles y con ello la dirección del vagón, pero al hacerlo, en lugar de cinco, moriría un solo ser.

Eso que se plantea es un reconocido dilema del campo de la filosofía moral. Los expertos exhiben este problema en una especie de encuesta en la que los participantes deben tomar en consideración varios elementos para decidir.

Una persona que tiene sólo un par de segundos, según el pensamiento común, selecciona la menor cantidad de muertes de acuerdo con los estudios históricos. Pero saber lo que haría una inteligencia artificial es el dilema actual ante un escenario similar.

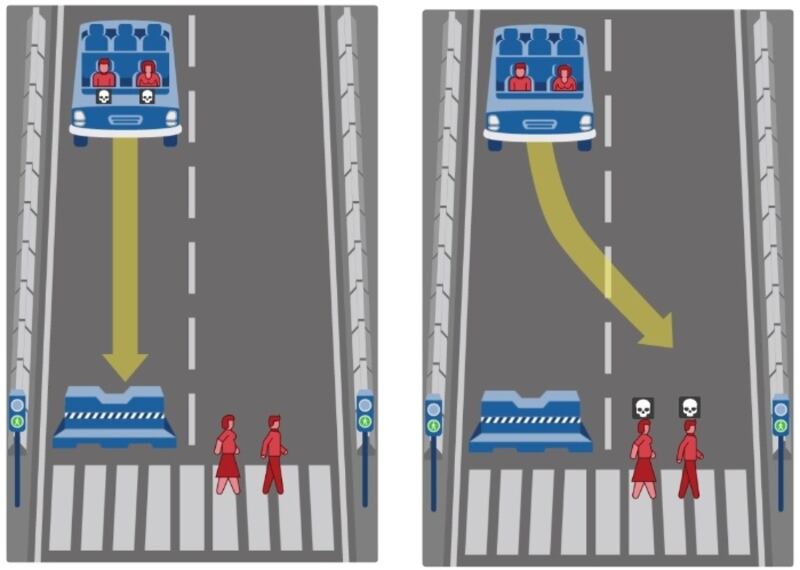

El portal de la Universidad de Iberoamericana, de la Ciudad de México, publica una nota en la que los expertos actualizan el mismo dilema de la imagen de arriba, pero con un vehículo autónomo que funciona con IA.

Para este escenario, el vehículo descontrolado se estrellaría y mataría a sus dos tripulantes o se desviaría y chocaría a peatones. De hecho, se plantean varias posibilidades en las que suman niños, mujeres, adultos mayores, personas en situación de calle y otras especificaciones para sumar planteamientos al cerebro.

Los estudios en personas siempre siguen eligiendo menor cantidad de muertes y personas jóvenes por encima de adultos. Pero la IA no parece estar preparada, ya que carece de criterio para la toma de decisiones morales.

PUBLICIDAD

Andrés Tortolero Baena, Coordinador de la Ingeniería en Ciencia de Datos de la Universidad Iberoamericana destaca a las personas por encima de las máquinas, debido que “se basan en un entorno, en un contexto, en percepciones que se van adquiriendo a lo largo de los años con base en la experiencia de las personas. Y aunque la inteligencia artificial adquiere conocimiento con base en la experiencia, no es la experiencia de algo vivido, sino algo aprendido, que se basa en la información que se le dé”.

Mientras que una IA todavía está en la fase de elegir entre lo correcto e incorrecto, que en el campo del dilema moral es muy complejo de percibir.