Los chatbots de inteligencia artificial (IA), como ChatGPT y Bard, no cumplen con los estándares legales establecidos por la Unión Europea (UE), según revela un reciente estudio realizado por investigadores de la Universidad de Stanford.

La Ley de Inteligencia Artificial de la UE, recientemente adoptada por el Parlamento Europeo y citada en un informe de Decrypt, es la primera regulación de este tipo a nivel nacional y regional.

No solo busca regular la IA dentro de los países miembros de la UE, que abarcan a una población de 450 millones de personas, sino que también establece un modelo para futuras regulaciones de IA en todo el mundo. Sin embargo, de acuerdo con el estudio de Stanford, las empresas de IA tienen mucho trabajo por delante si pretenden cumplir con esta legislación.

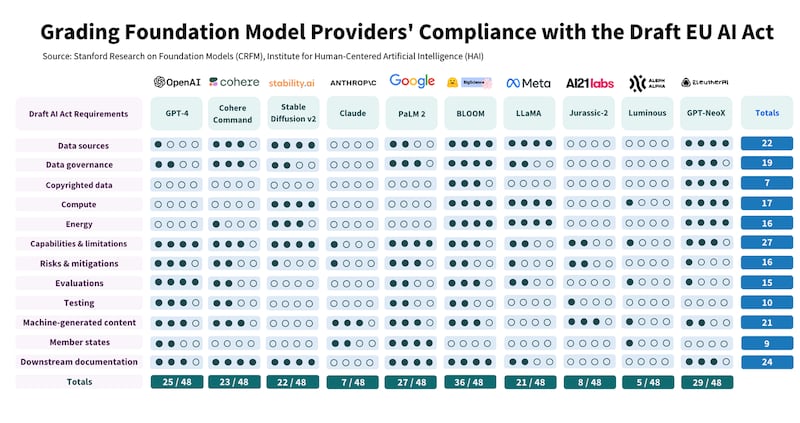

Los investigadores evaluaron a 10 proveedores de modelos de lenguaje extenso (LLM), analizando el grado de cumplimiento de cada uno de ellos con los 12 requisitos establecidos en la Ley de IA. Los proveedores fueron calificados en una escala del 0 al 4.

Los resultados del estudio

Los resultados revelaron una gran discrepancia en los niveles de cumplimiento, con algunos proveedores obteniendo una puntuación inferior al 25% en el cumplimiento de los requisitos de la Ley de IA. Solo un proveedor, Hugging Face/BigScience, logró una puntuación superior al 75%. Incluso los proveedores con puntajes altos tienen margen para mejorar de manera significativa, como señala el estudio.

El informe destaca puntos críticos de incumplimiento, como la falta de transparencia en la divulgación del estado de los datos de entrenamiento protegidos por derechos de autor, el consumo de energía y las emisiones generadas, así como la metodología para mitigar los riesgos potenciales.

Además, se observa una disparidad aparente entre los modelos de IA de lanzamiento abierto y cerrado. Los lanzamientos abiertos permiten una divulgación más sólida de los recursos, pero presentan mayores desafíos en términos de monitoreo y control de la implementación.

En los últimos meses, ha habido una disminución notable en la transparencia de los principales lanzamientos de modelos. Por ejemplo, OpenAI no ha revelado información sobre los datos y la computación en sus informes para GPT-4, citando la competencia y preocupaciones de seguridad.

Stanford concluye y señala que todos los proveedores podrían mejorar su conducta de manera factible, independientemente de su estrategia de lanzamiento. Según los investigadores, el principal desafío radica en la rapidez con la que los proveedores de modelos pueden adaptar y evolucionar sus prácticas comerciales para cumplir con los requisitos reglamentarios.